20 | DeepFM:如何让你的模型更好地处理特征交叉?

讲述:王喆

时长12:40大小11.60M

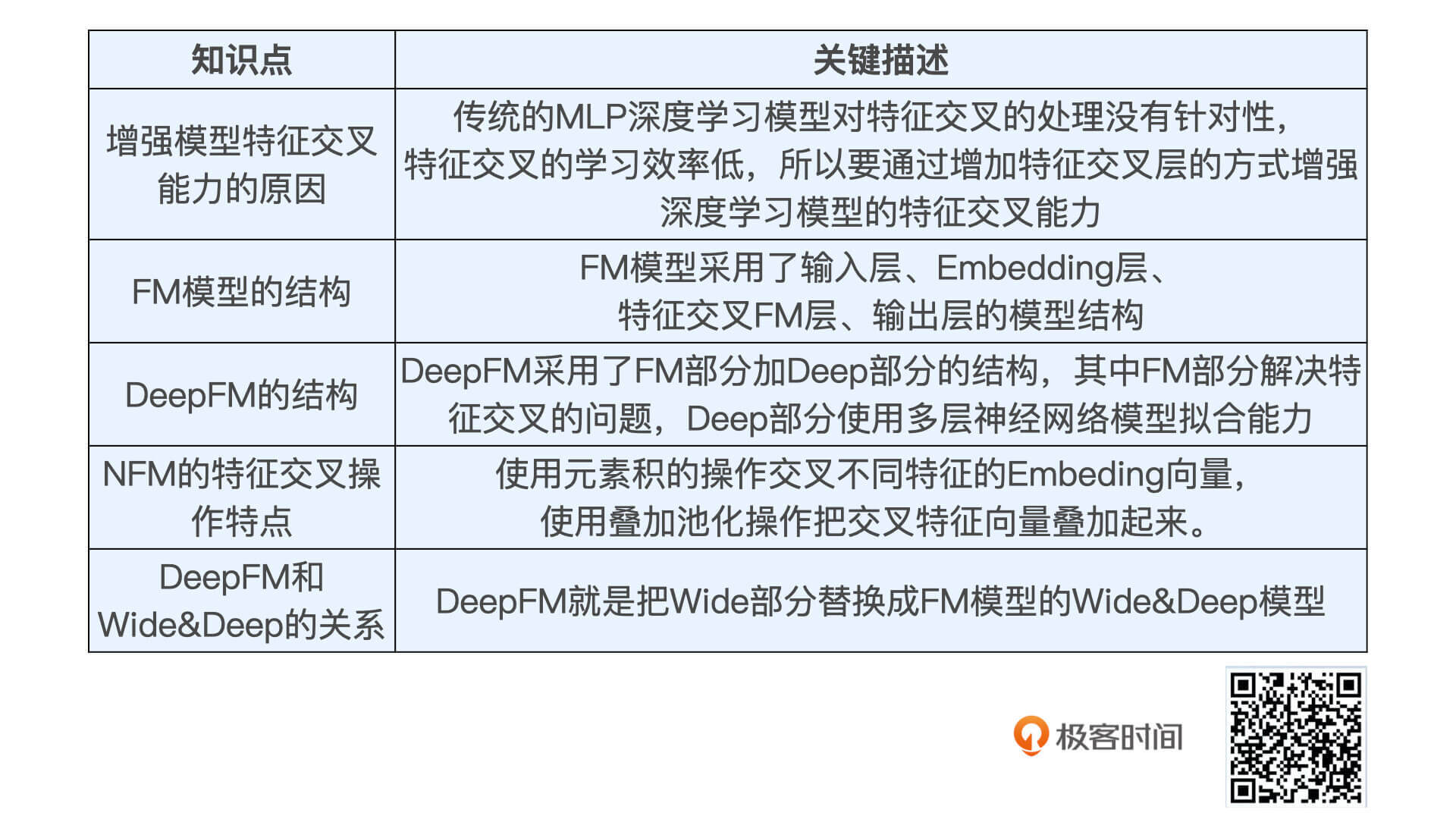

为什么深度学习模型需要加强特征交叉的能力?

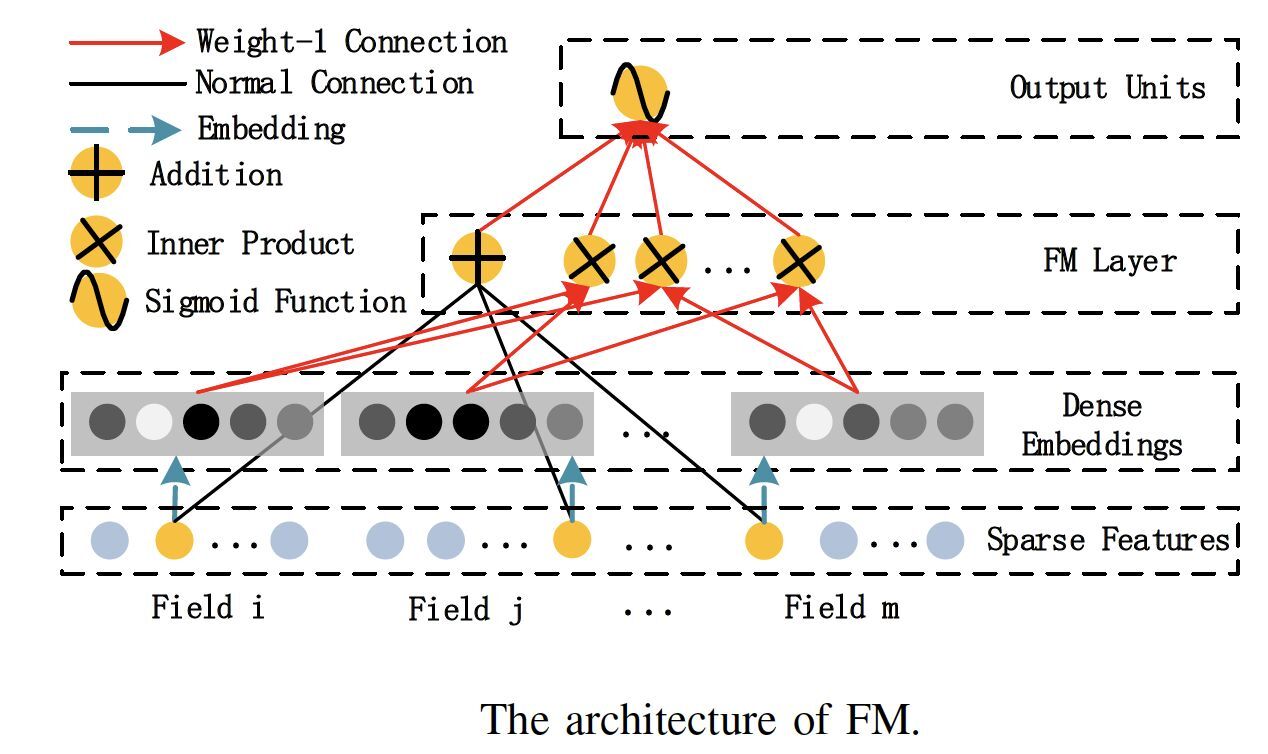

善于处理特征交叉的机器学习模型 FM

(出自论文 DeepFM: A Factorization-Machine based Neural Network for CTR Prediction)

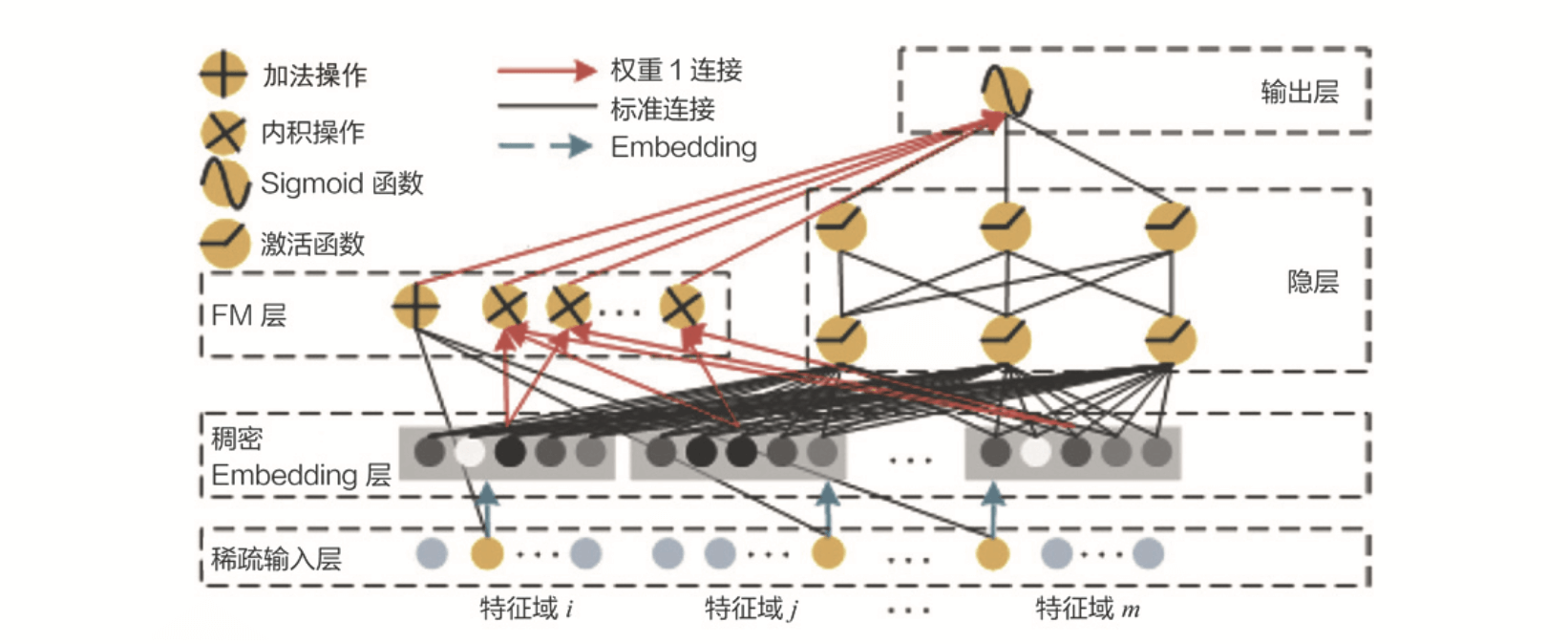

深度学习模型和 FM 模型的结合 DeepFM

(出自论文 DeepFM: A Factorization-Machine based Neural Network for CTR Prediction)

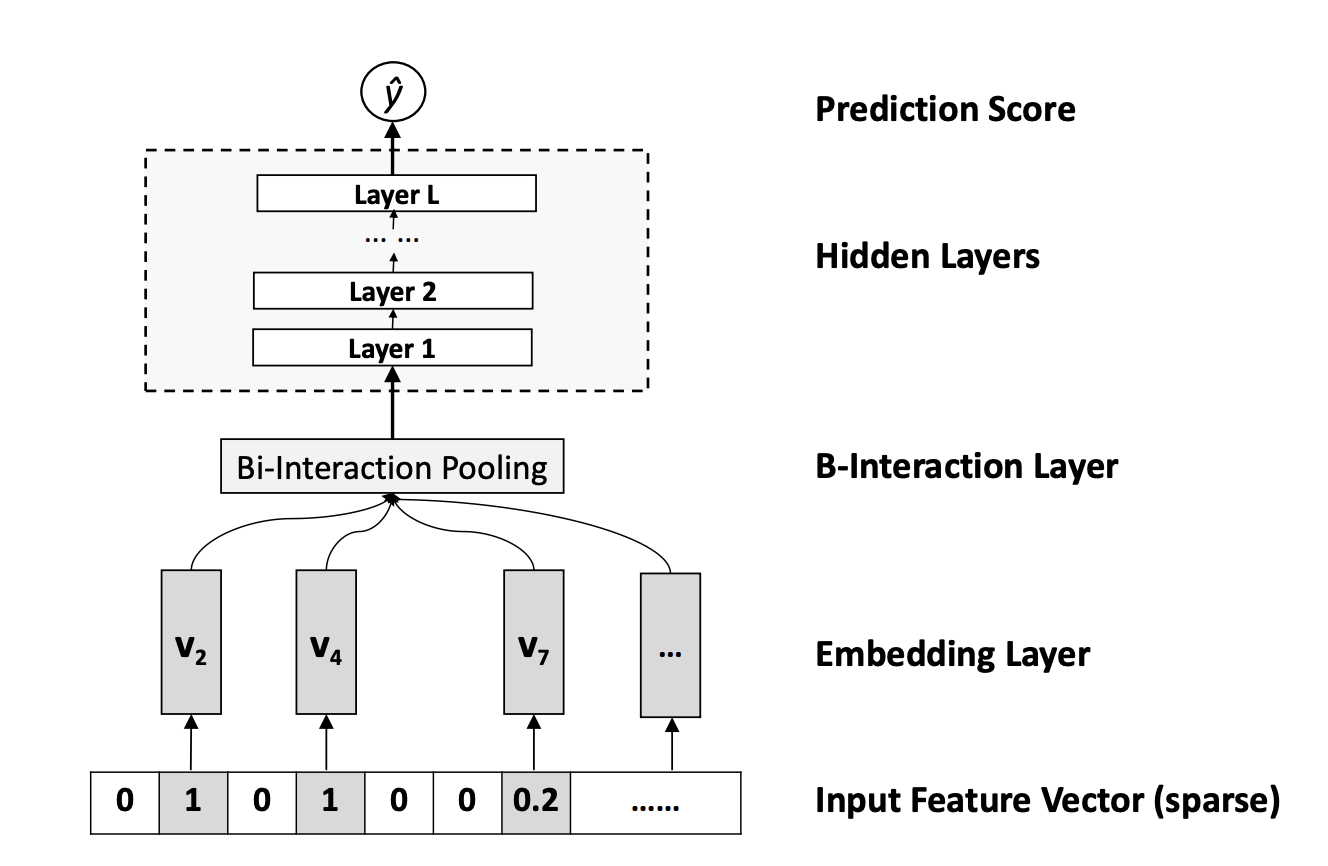

如何使用元素积的操作进行特征交叉?

(出自论文Neural Factorization Machines for Sparse Predictive Analytics)

DeepFM 的 TensorFlow 实战

小结

课后思考

精选留言(15)

- 2020-11-26关于DeepFM,想请教一下老师:DeepFM的图示中,输入均是类别型特征的one-hot或embedding,请问是因为特征交叉仅适用于类别型特征的交叉吗?数值型特征之间,数值型与类别型特征之间能否进行交叉呢?另外,在DeepFM的wide部分中一阶交叉项是否可以包含未参与特征交叉的数值型特征呢?展开

作者回复: 这是个好问题。按照DeepFM原论文,数值型特征是不参与特征交叉的,因为特征交叉的操作是在两个embedding向量间进行的。

但是如果可以把通过分桶操作把连续型特征处理成离散型特征,然后再加Embedding层,就可以让数值型特征也参与特征交叉。这是一个可行的方案。 4 - 2020-11-25关于课后思考题,处理两个 Embedding 向量间的特征交叉的方法。

1.是否可以把这两个embedding向量组合之后再做一次embedding。

2.对于两个Embedding向量做一次pooling层,采用average/max pooling。

另外,开个脑洞,不是有木有把点积和元素积一起使用的模型呢?展开作者回复: 这两个想法都没有问题,其实深度学习中没有什么不可以的,有的只是提出思路,改进模型,和验证效果。

把点积和元素积在一起使用,交给模型自动学习权重当然也是可行的。

除此之外,还有元素减,外积等交叉操作,除此之外还有一些自定义的复杂交叉操作,比如google cross&deep模型中自定义的一些cross操作。 4 - 2020-11-26老师您好,请教一个关于FM的问题。原FM中二阶交叉项中隐向量的内积仅作为权重,但从这篇课程的图示和代码来看,他们的内积直接作为了交叉项的结果,而没有了初始特征的交叉,想请问一下,这样做是因为教程里所选的特征是one-hot格式,所以维度可能不一致,从而无法进行初始特征的交叉吗?那对于数值型的特征,他们的初始特征交叉是否应该和隐向量内积相乘再作为二阶交叉项的输出呢?展开

作者回复: 是这样,原FM中内积作为权重,然后还要乘以特征本身的值。

但在DeepFM中,所有的参与交叉的特征都先转换成了embedding,而且由于是one-hot,所以特征的值就是1,参不参与交叉都无所谓。所以直接使用embedding的内积作为交叉后的值就可以了。

至于数值型特征的问题在于,如何把他们转换成embedding向量,我觉得分桶后加embedding层是一个方法,但其实分桶后加embedding层也是不用加原特征值的,因为分桶后的结果还是一个one-hot向量。 3 - 2020-11-26王老师,您好,我们的课程后续会讲召回后选集排序么?

作者回复: 这篇讲的深度学习模型就会应用到SparrowRecsys的排序层。

你讲的“选集”指的是? 2 1 - 2020-11-25请问老师,文中提到FM 和 DeepFM 中进行特征交叉的方式,都是进行 Embedding 向量的点积操作。FM层中还有个加操作,它的作用是什么?展开

作者回复: 加操作是不进行特征交叉,直接把原先的特征接入输出层,相当于wide&deep模型中的wide层。

2 1 - 2020-11-25这一讲里是关于不同特征之间的交叉,但对于之前提到过Youtube有对单一特征进行平方,开方这样的操作得出新的特征的做法,对于这种单一特征的变换操作有没有什么深度模型可以做到?还是一般都是根据经验和理性进行人工手动的尝试?展开

作者回复: 一般是通过人工经验进行一些预处理。当然,预处理层也可以看作深度学习模型的一部分,需要一些人工的尝试。

1 - 2020-12-03老师 您好!我准备做推荐项目场景为类似抖音这种的短视频信息流推荐 想请教一下:1、实际生产环境中tensorflow训练这些深度学习模型一般是分布式训练吧?如果是分布式训练的话,您sparrowrec项目中的代码需要做哪些改动?或者能否整体说明一下如果这个项目代码在生产环境使用的话有哪些需要注意应该要修改的地方。2、我看您代码中特征是存在reids中。想请教一下几百万用户(dau几十万)和几十万的视频 用户和物品特征一共300个字段左右 这种规模的数据量适合把用户和视频的特征都存在redis中吗?展开

作者回复: 1. 不一定,也有大量公司采用单机多卡的形式训练。如果是分布式的环境,改变会比较大,需要深入研究parameter server相关的配置和实践,属于非常偏工程前沿的内容了,需要大家自己去踩坑填坑。

2. 这个问题不用我回答,你自己estimate一下就可以了,redis的容量有多大,你的数据量有多大。然后做一个poc去先插入少量数据看一下实际的内存使用量就可以了。

如果redis容量不够怎么办,参考之前存储模块的那讲。 - 2020-12-021.两个embedding concat以后pooling (max average)都行

2.内积、外积展开作者回复: 是的

- 2020-12-01王老师,那个Fpix(Vx)中j的求和公式是不是有点问题呀?是不是应该是j=n+1~

作者回复: 非常好,确实有问题,应该是j=i+1。会更正。

- 2020-12-01老师您好,按FM的交叉方式,不同特征的embedding 向量维度要相同,但实际不同离散特征的维度可能相差很大,如果想用不同的embedding 维度,那应该怎样做交叉,业界有没有这样的处理方式?

作者回复: 几乎不可以。如果一定要做的话,也要在不同embedding层上再加上一层fc layer或者embedding layer,把他们变成一致的,然后交叉。

- 2020-11-28前面讲的wide&deep中wide主要是体现记忆性,对原始特征人为的把一些强特征做特征交叉;而deepFM,采用FM层自动的进行二阶特征交叉,并且采用了原始特征的embedding层。所以deepFM从效果上要比wide&deep要好一些,老师,大概是这个原因吧展开

作者回复: 是的,这两个模型的大致区别是这样。但也不能说效果一定就好,还是老话,好不好看自己实践。

- 2020-11-26老师好,请教个问题?讲了这么多模型,在实际的环境中,怎么做模型的选择,以及不同模型和策略之间叠加,以及不同策略实验的加入,从而增加推荐的精准度。

作者回复: 这是个好问题,但没有标准答案,还是要自己去做评估和多种模型的尝试和比较。之后我会介绍一些经验,在模型评估篇也有相关的知识。

- 2020-11-26老师你好,你的代码应该只是一个示例代码吧。FM部分只用到了四个特征,并不是原型FM的全部交叉,而且也没有一阶非交叉的特征,这应该只算是deep网络和手工交叉的组合,不能算是deepfm的实现吧

作者回复: 是的,只是一个示例。但通过加入一阶项修改成标准的deepfm应该很容易就可以实现。

可以帮我修改一下,之后提个pull request吗? - 2020-11-25对特征embedding做concat、average pooling、sum pooling 都可以

作者回复: 这些确实都可以,但针对性不强,还是一些专门针对两个embedding特征交叉设计的操作效果好一些。比如我们提到的dot product, element-wise product 和element-wise minus. outer product等等。

- 2020-11-25想请问下老师, 能简单介绍下因子分解机模型(Factorization Machine)和矩阵分解(matrix decomposition)之间的联系和差别吗?(我对于矩阵的很多模型算法都很懵,比如还有奇异值分解(singular value decomposition,NMF(Non-Negative Matrix Factorization),没有搜好的图示解释他们之间的渊源, 也请教老师和大家有什么好的学习资料)展开

作者回复: 结构上来说,因子分解机会引入除了user id和item id的其他特征,而且FM是有一阶部分的,不只是做特征交叉。

MF就是一个只利用user id和item Id的双塔模型。

当然像你说的,MF还有多种的求解方式,推荐找找相关资料,自己认真推理一下。